Die Zukunft vorstellen

Bei einer visuellen Inspektion der Unterwasserinfrastruktur mussten die Taucher mit Standbildkameras auf den Meeresboden fahren und hofften, dass das Kameragehäuse nicht überflutet oder dass der Film während der Entwicklung nicht überbelichtet oder zerstört wird. Selbst bei der Verwendung der ersten ferngesteuerten Fahrzeuge (ROV) mit Live-Video-Feed war es aufgrund der eingeschränkten Steuerungs- und Positionierungsfunktionen bei Vorhandensein eines Stromniveaus schwierig, ein Inspektionsziel lange genug zu sehen.

Man kann mit Sicherheit sagen, dass die Branche seitdem weit fortgeschritten ist und die Möglichkeiten der Bildgebung von Tag zu Tag größer werden. Tatsächlich beginnt das Problem zu werden, wie der „Tsunami“ der gesammelten Daten verarbeitet werden kann.

Diese Themen standen im Mittelpunkt eines gemeinsamen Seminars, das von der Hydrographic Society in Schottland (THSiS), der International Marine Contractors Association (IMCA) und der Society of Underwater Technology (SUT) im Oktober in Aberdeen abgehalten wurde.

Einerseits entwickeln sich Sensorplattformen weiter. Sowohl ROVs als auch autonome Unterwasserfahrzeuge (AUV) werden schneller verwendet. BP hat sich zum Ziel gesetzt, die Unterwasserinspektion zu 100% über maritime autonome Systeme (MAS) bis 2025 durchführen zu lassen, sagte Peter Collinson, leitender Unterwasser- und Umweltspezialist bei BP im Ölmajor, dem Seminar.

Sie werden auch autonomer und werden von Onshore-Operationszentren unterstützt. Equinor hat bereits Pilotversuche für ROV-Operationen in Onshore-Zentren (über Oceaneering und IKM) durchgeführt. In diesem Jahr soll Eelumes schlangenartiger Unterwasserroboter in einer Unterwasser-Garage des Åsgard-Feldes vor der Küste Norwegens an einer Kette getestet werden. Bis zum Jahr 2020 hofft es, kabellos zu werden, erklärte Richard Mills, Vertriebsleiter von Kongsberg Maritime Robotics, dem Seminar. Der nächste Schritt könnte in Kombination mit unbemannten Oberflächenbehältern erfolgen.

Mittlerweile helfen Bildgebungsverfahren - vom Laser bis zur Photogrammetrie - diesen Plattformen, mehr Daten schneller zu erfassen und möglicherweise auch zu navigieren.

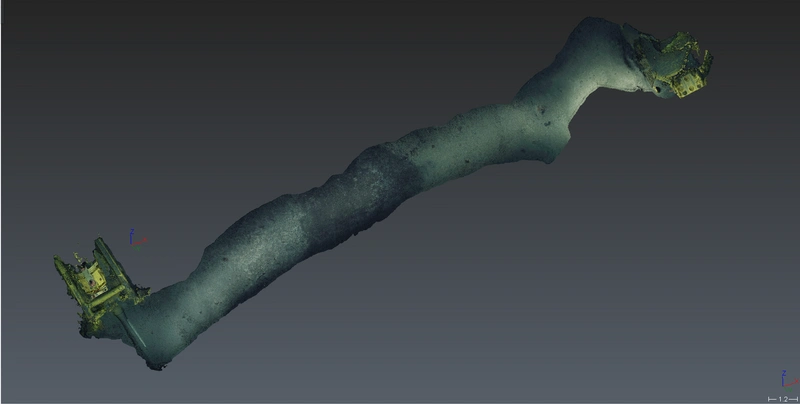

Unterseebefragungen unter Verwendung eines ORUS3D-Systems. (Quelle: Comex Innovation)

Unterseebefragungen unter Verwendung eines ORUS3D-Systems. (Quelle: Comex Innovation)

Ziemlich messbare Bilder

On the fly-Umfragen werden mit Hilfe der Photogrammetrie durchgeführt. Comex Innovation hat im Sommer 2018 zwei Offshore-Inspektionsprojekte in der Nordsee mit seiner ORUS3D-Unterwasserphotogrammetrietechnologie abgeschlossen. Zuvor hatte er bereits Projekte in Westafrika, Raymond Ruth, Großbritannien, und North Sea Agent für Comex Innovation durchgeführt. Für beide Operationen in Großbritannien und Dänemark war eine genaue Messung erforderlich, eine zur Unterstützung von Brownfield-Modifikationen.

Das Unterwasseroptiksystem ORUS3D misst und erstellt hochauflösende 3D-Modelle von Unterwasserstrukturen. Jedes System umfasst einen integrierten Strahl von drei Brennpunkten mit vier breitstrahlenden LED-Blitzgeräten sowie eine Datenerfassungs- und Datenverarbeitungseinheit. Sie verwendet die Triangulation der Features in den erfassten Bildern, um ihre relative Position zu lokalisieren und eine 3D-Punktwolkenrekonstruktion zu erstellen, die zur Messung verwendet werden kann, sodass ein Inertialnavigationssystem oder eine Zielposition auf dem Objekt zur Skalierung vor Ort nicht benötigt werden.

Die integrierte Einheit passt auf ein ROV, um Daten aus einer Entfernung von mehr als 40 cm von Strukturen freifliegend zu erfassen. Die beste Entfernung beträgt jedoch 1-2 m vom Objekt. Dies dauert nicht länger als eine allgemeine Videoumfrage, sagte Ruth.

Die erste Echtzeitverarbeitung an Bord wird durchgeführt, um den Standort und die Qualität vor der Verarbeitung vor Ort (auf dem Hilfsschiff) zu ermitteln, die Daten weiter zu überprüfen und ein anfänglich skaliertes 3D-Modell mit einer cm-Genauigkeit zu erstellen. Die endgültige Verarbeitung der Daten, die als Punktwolkendaten erfasst werden, wird dann ausgeführt, um den Standort oder das Objekt in einem 3D-Modell auf mm genau zu rekonstruieren.

Ergebnisse einer ORUS3D-Umfrage (Quelle: Comex Innovation)

Ergebnisse einer ORUS3D-Umfrage (Quelle: Comex Innovation)

Automatisiertes Eventing

EIVA habe an der Anwendung von Machine Learning und Computervisionstechniken gearbeitet, um Objekte wie Anoden an Rohrleitungen, Rohrschäden und Meerwasserwachstum unter Verwendung einer herkömmlichen Kamera automatisch zu erkennen, sagte Matthew Brannan, leitender Vermessungsingenieur bei EIVA. Maschinelles Lernen verwenden bedeutet, ein System mit Zehntausenden von Bildern aus Pipelines trainieren zu müssen. Dies ist, was die EIVA getan hat und sie trägt Früchte. Das Unternehmen hat Versuche mit vorhandenen Datensätzen durchgeführt, die auf herkömmliche Weise durchgeführt wurden. Daher war es möglich, die automatisierten Ergebnisse mit den von Menschen verursachten Ereignissen zu vergleichen. Ende 2018 startete es auch während des ROV-basierten Betriebs mit Live-Tests. Das ultimative Ziel der Technologie ist die automatische Ereigniserkennung während einer AUV-Vermessung, die es einem AUV ermöglicht, etwas zu erkennen und dann eine Nachricht an ein Oberflächenschiff zu senden, sagte Brannan.

EIVA führt auch herkömmliche Kameras weiter aus, verwendet simultane Ortung und Kartierung (SLAM) und Photogrammetrie, um Kartenbereiche zu erstellen, und kann die Position der Kamera relativ zu der Kartierung lokalisieren. Bestehende SLAM-Systeme sind auf das Schließen der Schleife angewiesen, und Photogrammetrielösungen erfordern viel Bildüberlappung und gute Sichtbarkeit und sind normalerweise nicht in Echtzeit, erklärte Brannan. Einige setzen auch auf teure Stereokameras, die kalibriert werden müssen und Platz beanspruchen, sagte er.

EIVA nennt sein System VSLAM oder visuelle SLAM. Durch die schnelle Erzeugung einer Punktwolke kann VSLAM sich selbst (dh das Fahrzeug, in dem sich das Fahrzeug befindet) in seiner Umgebung lokalisieren und das von ihm erstellte Modell verwenden, um Unterwasserstrukturen automatisch zu verfolgen und zu scannen. Dies sei mit einer einzigen Kamera möglich, so Brannan, und aus Standbildern oder aus Videos extrahierten Bildern, indem Punkte in jedem Bild nachverfolgt und mithilfe dieser Punkte eine Spur geschätzt wurde, um die spärliche Punktwolke zu erstellen und ein digitales Geländemodell zu erstellen. Ein AUV würde auch seine ursprüngliche absolute Position kennen und könnte dann Wegpunkte (dh Landmarken) entlang der Route verwenden.

Die Punktwolke kann dann verwendet werden, um eine dichte 3D-Punktwolke und dann ein Netz mit Farbe und Textur zu erstellen. EIVA hat seit 2017 mit einem Team daran gearbeitet und testet das System jetzt an AUVs. In diesem Jahr wird es Live-Projekte mit visueller Navigation geben, sagte Brannan. Danach will es autonome Inspektionen und leichte Eingriffe unterstützen.

subSLAM

Rovco hat die Vision, ein AUV mit einem autonomen Oberflächenfahrzeug (ASV) einzusetzen, um mit seiner Live-3D-Bild- und Kartentechnologie SubSLAM Umfragen und Kartierungen durchzuführen. Mit SubSLAM kann ein ROV schnell eine 3D-Karte seiner Umgebung erstellen, ohne andere Trägheitsnavigations- oder Positionierungssysteme zu verwenden. Die Firma nennt es Live-3D-Computer Vision.

Rovcos Live-SubSLAM-Konzept (Quelle: Rovco)

Rovcos Live-SubSLAM-Konzept (Quelle: Rovco)

Die SubSLAM X1 Smart Camera-Technologie von Rovco verwendet ein Dual-Kamerasystem, um eine Live-Punktwolke zu erzeugen. Dies wird dann verwendet, um die Position des Fahrzeugs relativ zu dem, was es betrachtet, zu berechnen.

Joe Roco habe SubSLAM auf einem Sub-Atlantic Mojave-Beobachtungs-ROV verwendet, macht es jedoch mit anderen Plattformen kompatibel, sagte Joe Tidball. Das Unternehmen plant, in diesem Jahr seinen ersten AUV, einen Sabertooth, von Saab Seaeye zu erwerben, im Jahr 2020 SubSLAM zu integrieren und dann 2021 künstliche Intelligenz (KI) in das System zu integrieren. Danach sollen Umfragen von einem ASV aus dem Jahr 2022 durchgeführt werden.

Tidball sagte, das System sei für Unterwassermesstechnik geeignet und könnte mit einem drahtlosen drahtlosen Fahrzeug verwendet werden, das mit einem Oberflächenkommunikations-Gateway mit Funk- / Mobilfunk- oder Satellitennetzen und dann mit der Cloud verbunden ist, wo Ingenieure auf ein browserbasiertes Messwerkzeug zugreifen können - mit Live-3D-Daten gespeist werden. Mit KI könnte das Fahrzeug dann selbst Bewertungen vornehmen.

Rovco testete sein SubSLAM-System im August 2018 im Offshore Renewable Energy Katapult in Blyth, Nordostengland. Tidball sagte, das Unternehmen habe die Messgenauigkeit getestet, die es mithilfe von terrestrischen Vermessungsdaten an Bauwerken in einem Trockendock erreichen könne, das dann SubSLAM überfluten könne erledige seine Arbeit in 1,2 m Sichtweite. Die Unterwasserdaten wurden mit einem Laserscan verglichen. Verglichen mit den zwei Stunden, die für eine Open-Air-Vermessung mit 1,7 mm Ausrichtungsfehler benötigt wurden, erzielte SubSLAM einen Fehler von 0,67 mm aus einem zweiminütigen Scan, sagte Tidball.

Tidball sagte, das System könne die Notwendigkeit von Long-Base-Line-Systemen (LBL-Systemen) für die Positionsgenauigkeit aufheben. Die Sichtbarkeit war jedoch ein Faktor, damit die Kameras funktionieren. Während die Technologie in der Lage ist, das ROV oder AUV in seiner Umgebung zu positionieren, wenn es zu einem anderen Standort umzieht und ohne Kabel wäre, wäre eine Trägheitsnavigation erforderlich.

Zurück in die Zukunft

Die Techniken, mit denen Punktwolken schnell erstellt werden, können auch zum Erstellen von Punktwolken aus vorhandenen Bildern oder Videomaterial verwendet werden, sagte Dr. Martin Sayer, Geschäftsführer von Tritonia Scientific aus Schottland. Beispielsweise verwendete Tritonia seine Technologie als Teil einer Nettoumweltnutzungsanalyse einer Plattformjacke an einem tropischen Standort, in der ein Betreiber feststellen wollte, wie viel zusätzliches Gewicht das Wachstum einer Jacke für die Hebemaßnahmen hinzufügen würde, um Berechnungen des Hubvorgangs und die Entsorgung an Land durchzuführen Planung. Tritonia erhielt vorhandenes ROV-Material zur Bewertung. Dies wurde für Fischlebensumfragen verwendet, nicht für das Biofouling von Jacken. Daher wurde es nicht für die 3D-Modellierung entwickelt oder konzipiert. Auf dem ROV waren zwei HD-Kameras und eine Standardkamera montiert, links, rechts und zentral.

Aufgrund des Lichts im Wasser und des Großteils der Aufnahmen, die auf Fische gerichtet sind, waren etwa 95% davon nicht verwendbar. Der Rest wurde nachts gedreht, wodurch er besser geeignet ist, ohne Oberflächenstörungen und besseren Kontrast, so dass ein fast vollständiger Beinabschnitt modelliert werden kann. Durch Entfernen des bekannten Beinvolumens aus dem Modell kann das marine Wachstumsvolumen berechnet werden.

On the fly

Für einige ist das reale Potenzial all dieser Technologien die Möglichkeit, Daten live zu verarbeiten und diese Informationen zu nutzen, um in (wenn auch überwachte) Live-Systeme zurückzugreifen.

Es gibt eine Rückkopplungsschleife, die diese Operationen leistungsfähiger macht. "Die Verarbeitung der Daten [die wir sammeln] erfolgt automatisch, wenn wir an Wert gewinnen", sagte Nazli Deniz Sevinc, Projektleiter bei UROV, OneSubsea. "Außerdem ist es eine Rückkopplungsschleife für überwachte Autonomie-Algorithmen und die Erkennung von Funktionen", so Brannan.

Es passiert viel. Überwachte Autonomie, autonome Fehlererkennung, unbemannter Betrieb ohne Hilfsschiffe sind das Ziel. Es gibt Hürden, wie zum Beispiel die Gesetzgebung, die im Bereich der unbemannten Schiffssysteme hinter der verfügbaren Technologie steht. Es gibt Probleme mit Datenstandards und dem Umgang mit der Datenmenge, die gerade erstellt wird, und die Anpassung dieser Techniken an die heutigen Arbeitsabläufe (oder die Anpassung der Arbeitsabläufe selbst). Es ist ein sich schnell bewegender Raum, in dem Sie eine Menge unscharfer Grenzen sehen können (wenn nicht Bilder).

Daten-Tsunami

Neue Imaging-Technologien schaffen neue Möglichkeiten für die Unterwasservisualisierung und -autonomie. Sie stellen auch eine Herausforderung für die Betreiber dar, die sich mit dem "Daten-Tsunami" beschäftigt. Peter Collinson von BP sagte: „Eine der größten Sorgen ist (dass) wenn Sie anfangen, Flotten von AUVs dorthin zu schicken, werden wir einen Tsunami von Daten haben. Wir haben uns auf [Sensor / Survey] -Plattformen konzentriert, weil wir immer noch Vertrauen in das schaffen, was diese Systeme sind und was sie tun können. Das Datenstück kommt… mit dem richtigen Umgang mit diesen Daten. Wie können wir einen digitalen Zwilling bilden und eine automatisierte Änderungserkennung mit Zeitreihen durchführen? "

Während sich die Datenerfassung rasch weiterentwickelt, liegt der Fokus in der Zukunft auf der Datenlieferung an die Menschen, die sie benötigen, wie etwa Pipeline-Ingenieure, in einem Format, das sinnvoll und nützlich ist. Künstliche Intelligenz (KI) werde, so Malcolm Gauld, von Fugro helfen, Cloud Computing einzusetzen und Anomalien oder Defekte automatisch zu erkennen. Es werde jedoch Zeit brauchen, um Systeme zu entwickeln, sagte er. Fugro arbeitet daran und hat Versuche in Perth durchgeführt, die dazu beigetragen haben, Probleme mit der KI hervorzurufen, beispielsweise die Unterscheidung einer silbrigen Pipeline-Beschichtung von einem Hai. Zukünftige Schritte umfassen den Aufbau von Autonomie in diese KI. Gauld schlug jedoch vor, auch neue Modelle zu betrachten. Könnten Pipelines mit Sensoren gebaut werden, so wäre dies von Anfang an „intelligent“, wenn es um die Wartung der Instandhaltung geht, fragte er. "In Zukunft wird es nicht darum gehen, mit welcher Ausrüstung Sie diese Daten erhalten, sondern wie Sie diese Daten nutzen."

Tatsächlich werden wir uns diese Daten nicht einmal ansehen, schlug Joe Tidball, leitender Vermesser bei Rovco, vor. Künstliche Intelligenz, Robotik, übernimmt die Interpretation und Entscheidungsfindung. „Ich glaube nicht, dass wir uns in 10 Jahren mehr Videos anschauen werden. Wir werden einfach Berichte von Robotern in der Nordsee per E-Mail erhalten, die besagen, dass Sie sich XYZ ansehen müssen. “

Schnelle Pipeline-Inspektion

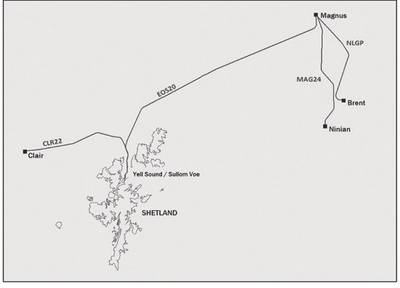

Bei Pipeline-Umfragen konzentrierte sich BP darauf, die Dinge schneller zu erledigen. Im Jahr 2017 beauftragte BP DeepOcean mit einem „Fast ROV“ (Bild oben, Superior ROV vom norwegischen Kyst Design), um 478 km der Pipeline (Karte unten) zwischen den Anlagen von Clair und Magnus in der Nordsee bis zum Sullom Voe Terminal (Onshore) zu untersuchen Shetland und von Brent und Ninian bis Magnus, alles in weniger als vier Tagen. Die Umfrage umfasste Laser-, HD-Standbildkameras und Field Technology-Systeme zur Feldgradientenüberwa- chung (FIG) und die durchschnittliche Inspektionszeit von 5,1 kt / h, 6x schneller als ein Standard-ROV und 5x schneller als ein modifizierter Standard-ROV, sagte Collinson . Es enthielt auch Side-Scan- und Multibeam-Vermessungsdaten. Das Endergebnis war eine 3D-Szenen-Layer-Datei, ein 2D-georeferenziertes Mosaik und Ereignis- / Anomalielisten.

Ein Kyst-Design-Superior-ROV, das für die Pipeline-Umfrage von BP durch DeepOcean eingesetzt wird (Quelle: BP)

Ein Kyst-Design-Superior-ROV, das für die Pipeline-Umfrage von BP durch DeepOcean eingesetzt wird (Quelle: BP)

Das Pipeline-System wurde vier Tage lang befragt (Quelle: BP)

Das Pipeline-System wurde vier Tage lang befragt (Quelle: BP)

Ein Abschnitt der Pipeline, der auf der Umfrage abgebildet ist (Quelle: BP)

Ein Abschnitt der Pipeline, der auf der Umfrage abgebildet ist (Quelle: BP)

Dehnung der Akustik

Die Schlumberger Firma OneSubsea arbeitet an einem Projekt namens uROV. Sein Ziel ist ein ortsgebundenes ansässiges Unterwasserfahrzeug mit kontrollierter Autonomie, das heißt, es ist möglich, per Video mit dem Fahrzeug vom Land aus zu kommunizieren. Aber während die von 4G-Mobilfunknetzen Offshore verfügbaren Videokommunikation über das Wasser geöffnet wird, sind die Videoverbindungen über Wasser nicht so einfach, sagte OneSubsea, Projektleiter von Nazli Deniz Sevinc, der SUT (International Marine) Contractors Association (IMCA) und das gemeinsame Seminar der Hydrographic Society in Schottland (THSiS) im Oktober.

Das UROV-Programm von OneSubsea plant die Verwendung eines Saab Seaeye Sabertooth-Fahrzeugs, das mit Schlumberger-Technologien ausgestattet ist. Die Vision von uROV liegt irgendwo zwischen einem AUV und einem manuell betriebenen ROV und bietet ungebundene, aber überwachte Autonomie, sagte Sevinc. Dies würde bedeuten, dass sich ein Mensch in der Schleife befindet, während er in Entfernungen von bis zu 3 km von einem Oberflächen-Kommunikations-Gateway arbeitet, z. eine unbemannte Oberfläche. Bei einer Unterwasserinfrastruktur in der Nähe hätte es auch eine Durchwasserdatenverbindung von bis zu 200 Metern.

Dies würde den Zugang zu Unterwasserfahrzeugen rund um die Uhr ermöglichen. Dies bedeutet jedoch, dass Sie Unterwasser-Wi-Fi, erweiterte Sensorik, visuelle Sensorik, fortschrittliche Steuerung und automatische Analyse benötigen. Sevinc sagte, der uROV werde EIVA Navisuite für die Missionsplanung und eine für den Sabertooth entwickelte Autonomieebene verwenden. Dies setzt jedoch auf Echtzeit-Feedback, das auf Kommunikation basiert.

Für den Brownfield-Betrieb zielt uROV auf akustische Kommunikation ab, was eine niedrige Datenrate bedeutet. OneSubsea hat über seinen Eigentümer Schlumberger-Standort in Boston daran gearbeitet, wie viel Daten es durch 100 kpbs erreichen kann. Im Jahr 2017 sagte Sevinc, die Firma habe die Übertragung von Boot zu Boot durch einen akustischen Kanal bei 100 kbps über 1 km erreicht. Mit einer vertikalen Übertragung wurden ähnliche Ergebnisse erzielt. Sevinc sagte, dies sei eine Obergrenze für Video, wobei die verbleibende Bandbreite für Befehle verwendet werde. Im Laufe des Jahres 2018 wurde diese Funktion in den uROV integriert. Geplant ist, die Fähigkeit zu entwickeln, Videodaten in diesem Jahr über 3 km zu übertragen, und bis zum Jahresende sollen sie implementiert werden. Ein weiteres Kit, das in den uROV integriert wird, umfasst die LiDAR-Lasertechnologie (Light Detection and Ranging) von 3D at Depth.

-168002)

-167856)

-167623)

-167415)

-167309)

-167178)

-166941)